在数字化转型速度不断提升的今天,大带宽、低时延、高并发的场景不断涌现,终端用户对于网络内容反应速率要求提升,对于CDN的应用需求也在不断攀升。而今正值中国CDN发展十年转型期,提升CDN核心竞争力,以CDN为切入点带动边缘计算、分布式云计算、音视频直播、云游戏等服务,为用户打造更高质量的CDN服务将成为新时代产业竞争的关键所在。

8月25日,以“新征程,耀一起”为主题的2022亚太内容分发大会暨CDN峰会在北京隆重开幕,本届大会由亚太CDN产业联盟、众视Tech联合主办。亚太CDN产业联盟携手阿里云、腾讯云、网宿科技、火山引擎、天翼云、中兴通讯、金山云等内容分发领域头部企业,为行业破旧立新、闪耀新征程发出最强音!

在8月25日下午举办的【边缘计算论坛】上,阿里云技术专家 徐若晨发表了题为《边缘容器云平台的探索和实践》的主题演讲,基于阿里云大规模边缘容器云平台展开介绍阿里云边缘容器云平台的发展背景、历程、设计与架构,深入解析了阿里云边缘容器云平台上的典型业务场景与实践案例,本文为整理内容。

立足于用户视角构建“云边端”一体化平台

从用户视角出发,当前在边缘侧业务面临挑战众多:

· 自建边缘机房交付周期长、资产重;

· 边缘集群常态化裁撤、割接,SLA难保障;

· 单集群业务规模小、弹性差;

· 属地性应用多,集群维护成本高、难度大;

通过在中心和客户现场之间,构建起边缘云这一层服务,就能够解决以上问题。边缘云为用户带来的对应方面价值主要体现在:

· 提升效率:为终端提供距离更近、时延更低的算力资源,支持时效性强、交互性强的业务场景,实现秒级算力交付;

· 降低成本:通过终端上移这一手段有效提升部分业务灵活性,实现按量付费、弹性扩容,降低客户的成本;

· 易运维:采用云原生交付方式,提升边缘应用可运维性,降低客户运维投入

· 低时延、提升用户体验:基于海量低延时的边缘集群资源覆盖,为客户提供时延更低的体验;

基于“云-边-端”的架构模式,边缘云实现了云端算力下沉与终端算力上移:

· 云端算力下沉:通过将应用、算力分布式部署边缘,从而卸载掉中心Region核心服务的负载。考虑到中心Region带宽的成本远高于边缘,因此对于带宽较大的业务,在边缘云实现流量的收敛再回到中心,能够大幅度缩减带宽的成本,为客户提供离终端更近的算力资源,提升业务交互性与时效性;

· 终端算力上移:对终端应用进行瘦身的同时为应用开发者提供标准化运维与云边体验一致的开发过程,帮助快速开发、迭代。对比终端应用,边缘云拥有更加丰富的生态,提升业务灵活性。除此之外,边缘上提供专属GPU硬件,进一步优化应用性能。

深度解析边缘容器云平台架构 精准应对技术挑战

边缘容器云平台技术挑战

边缘容器云平台的技术挑战主要是来自于三方面:

首先是集群规模小而多。受限于边缘的物理环境,单个集群的规模通常有限。随着资源的进一步下沉,终端算力的进一步上移,各类资源被纳管到边缘云中,资源规模迅速增长,边缘规模呈现出小型化、广覆盖的特点,为资源管控、弹性调度带来技术挑战;

二是边缘环境复杂。处于边缘的设备工作状态与条件对比数据中心更差,往往存在弱网、断网等情况,对于边缘自治、云边协同、边边协同、跨节点迁移能力、故障逃逸能力提出较高要求;

三是边缘基础设施异构。出于成本考量、业务定制化需求的考量,硬件操作系统、网络结构等方面存在明显异构场景,给资源的云化纳管工作造成困难;

边缘容器云平台架构

物理资源层包括多云融合资源、MEC、ARM阵列、自有节点、多云融合资源等,上层为资源建设与运维平台,提供基础的IaaS服务。

中间层从下往上,首先由异构资源纳管部分负责将IaaS资源以k8s节点形式接入k8s集群中;正如前文所述,单一的或少量的k8s集群无法容纳所有资源,所以基于异构资源纳管层需要构建多集群管理与调度融合能力,为上层提供标准的k8s界面;在标准k8s界面的基础上进行边缘能力的加强,包括边缘容器镜像、边缘工作负载、边缘服务网格、边缘应用管理等。

最顶层是边缘能力开放层,通过提供OpenAPI、开发者工具、能力开放平台等,使得用户、开发者可以通过开放层去使用阿里云边缘容器平台的各项能力来管理自己的业务。

针对中间层的边缘容器云平台将展开进行介绍:

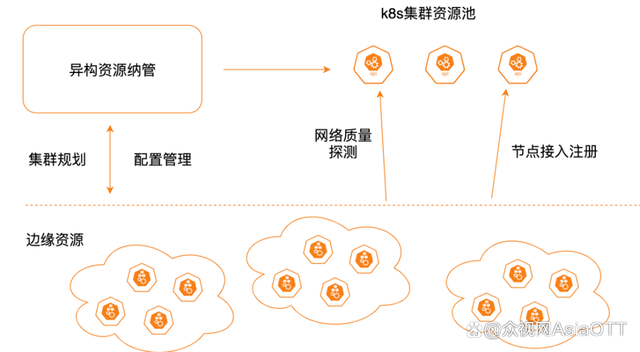

异构资源纳管

异构资源纳管核心功能是将边缘资源以k8s节点形式接入集群中,如图所示为标准化接入流程,适配了MEC、ARM等各种业务场景。接入过程中同时感知集群水位分布与边缘资源网络状态等多维度指标,选择最优接入集群,基于组件预置等技术方案减少接入过程中如组件安装、下载等时间成本,加速接入流程。

多集群管理

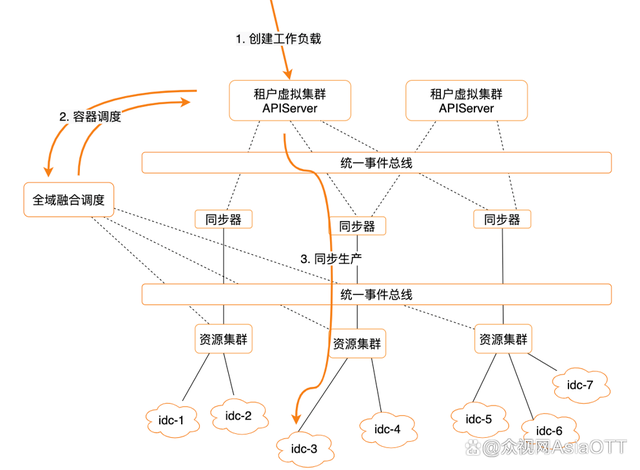

多集群管理流程如图所示,客户通过虚拟集群创建工作负载与pod,基于全域融合调度器,实时感知资源集群状态选择最优调度结果,将结果反馈租户虚拟集群中,利用同步器进行向下同步生产工作。

过程中将k8s集群分为两类,资源集群与为租户创建的独立虚拟集群。通过多层树状拓扑结构使每一个独立虚拟集群能够通过原生k8s语义使用全域边缘资源,并且提升了租户间的隔离性。

对于k8s集群的读操作通过统一事件总线完成,而非直接对k8s集群进行操作。因此每个k8s集群都能有效控制集群上的客户端数量,减少服务器上list-watch的消耗,并且使系统具备水平扩展能力。

全域融合调度在模型中作为k8s集群的总调度器,类比于大脑这一角色,有效实现了全域资源的多维度实时感知与多层次调度。

边缘特性增强

由于边缘资源单集群数量较多,因此需要通过单元化管理的概念将其映射到边缘的多个集群上,同时完成单元间的并行分发,以此提升业务发布效率。阿里云通过自研适配边缘场景的工作负载,对每一台机器上的每一个pod版本更新实现精准控制,使得系统更契合边缘异构场景上的容器与多开场景。

基于阿里云内容分发网络的技术与生态优势,构建出具备全网缓存与加速能力的边缘镜像服务,对于大规模流量并发提供支持,实现容器扩容,提高创建速度。

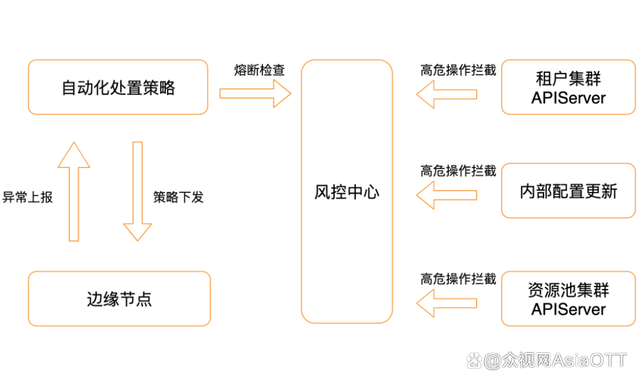

稳定性体系

基于阿里云内容分发网络构建的管控命令传播网络,使管控命令可以低延迟,高触达地下发到机器上执行。目前所有的云边管控操作都通过云边管控通道实现,在边缘节点出现异常的情况下,将按照异常上报,由中心进行处理策略匹配工作,熔断检查,最后将自动化处理策略下发至边缘节点形成闭环。

风控中心组件除去前文提到的熔断检查工作,还具备高危操作拦截能力,如k8s集群中大量node删除、pod对象删除、工作负载删除、权限修改、大规模标签修改等,帮助客户业务实现稳定运行,为系统保驾护航。

两大典型业务场景 构建边缘容器云平台最佳实践

中心业务下沉

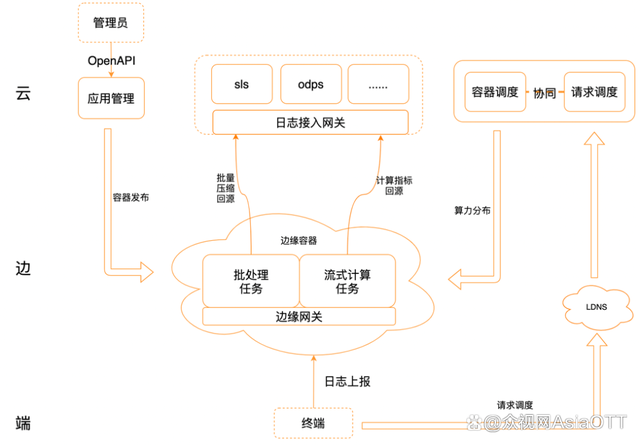

日志网关下沉场景,包括httpdns、内容安全识别下沉,本质都是中心业务的下沉。

终端通过请求调度寻找边缘节点,通过边缘网关服务将日志上报到容器中,此处请求调度与容器调度是协同工作的。例如业务容器CPU内存消耗的水位,将会影响请求调度的策略生成,水位高的情况下对请求调度节点进行修改。此外,请求调度同时影响容器调度,例如在集群副本数不够的情况下,触发容器调度对容器进行扩容操作。二者相互协同工作实现日志下沉。

中心下沉场景业务逻辑本质是通过云边端协同操作,节省中心带宽成本,降低接入延时,为客户打造最佳使用体验。

终端上云

机顶盒上云是终端上云场景的一类典型应用场景,同类场景还包括云手机、云游戏等。

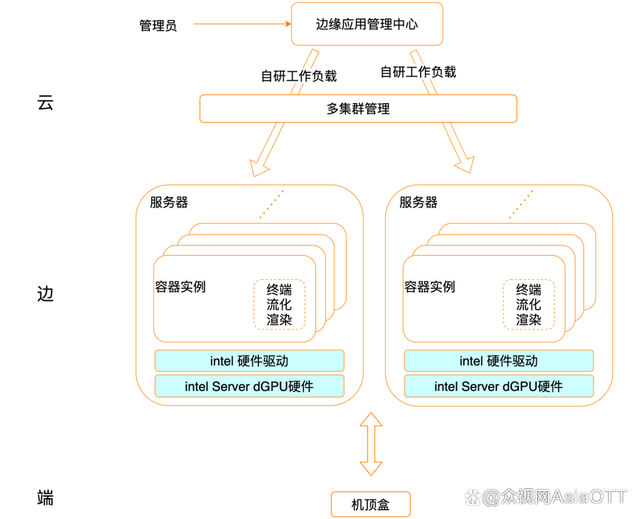

管理员通过应用管理中心,通过阿里云自研工作负载与多集群管理等方式将容器运行在边缘服务器上。如图所示为一组多开容器实例,通过自研工作负载精准控制每一个服务器上的每一个容器版本。同时,阿里云与英特尔合作,于服务器上安装Intle Server dGPU,对终端流化渲染性能实现进一步提升。

终端上云场景中,核心应用上移帮助终端瘦身,将更多的应用运维与管理开发工作集中在边缘,实现了对业务灵活性与使用性能的优化。

评论前必须登录!

立即登录 注册